豆包两款视频生成模型发布!多个垂类模型上新,基础模型研发全面发力!

豆包两款视频生成模型发布!多个垂类模型上新,基础模型研发全面发力!

Date

2024-09-24

Category

Tech

豆包视频生成模型于 9 月 24 日在火山引擎 AI 创新巡展深圳站发布。该模型采用高效的 DiT 融合计算单元,可更充分压缩编码视频与文本,全新设计的扩散模型训练方法带来了一致性多镜头生成能力,深度优化的 Transformer 结构大幅提升视频生成的泛化性。

现场还发布了豆包音乐模型、豆包同声传译模型,另有豆包大模型家族升级。本文介绍了活动发布的核心亮点。

9 月 24 日,2024 火山引擎 AI 创新巡展深圳站带来了豆包大模型最新进展。

现场重点发布了豆包视频生成模型、豆包音乐模型、豆包同声传译模型。

此外,豆包通用模型 pro 和文生图模型、语音合成模型等垂类模型也迎来升级。

1. 两款视频生成模型重磅发布,提供影视级视觉感受

本次活动带来豆包视频生成-PixelDance 、豆包视频生成-Seaweed 两款大模型,现已面向企业市场开启邀测。

高效的 DiT 融合计算单元,可更充分地压缩编码视频与文本,加之全新设计的扩散模型训练方法,带来了多镜头切换保持一致能力。在此基础上,团队还优化了扩散模型训练框架和 Transformer 结构,大幅提升视频生成的泛化性。

上述技术优势具体表现在如下方面:

- 精准语义理解,多主体、动作交互

豆包视频生成模型可以遵从复杂的用户提示词,精确理解语义关系,解锁时序性多拍动作指令与多个主体间的交互能力。

提示词:一名中国男子端起咖啡喝了一口, 一名女子走到了他身后

提示词:一对长头发的外国男子和女子在骑马驰骋

- 强大动态与酷炫运镜,告别PPT动画

运镜是视频语言的关键之一。豆包视频生成模型可以让视频在主体的大动态与镜头中炫酷切换,拥有变焦、环绕、平摇、缩放、目标跟随等多镜头话语言能力,灵活控制视角,带来真实世界的体验。

提示词:一名亚洲男子带着护目镜游泳,身后是另一名穿潜水服的男子

提示词:一位女性喝了一口咖啡,然后端着咖啡,带着伞走了出去

- 一致性多镜头生成,10秒讲述完整故事

一致性多镜头生成是豆包视频生成模型的一项特色能力。在一句提示词内,实现多个镜头切换,同时保持主体、风格和氛围的一致性。

提示词:一个女孩儿从汽车上下来,远处是夕阳

提示词:一名外国男子在冲浪,对着镜头竖起大拇指

- 高保真高美感,支持多种风格比例

豆包视频生成模型支持丰富多样的题材类型,以及包括黑白、3D动画、2D动画、国画、水彩、水粉等多种风格。同时,模型涵盖1:1、3:4、4:3、16:9、9:16、21:9 六个比例,充分适配电影、电视、电脑、手机等多种场景。

提示词:梦幻场景,一只白色的绵羊,带着弯弯的角

提示词:水墨风格的鸟,比例 16:9

2. 全新音乐模型、同声传译模型,满足多样需求

豆包视频生成模型之外,本次活动还发布了豆包音乐模型以及豆包同声传译模型。

- 豆包音乐模型

豆包音乐模型采用独特的技术方案,实现了音乐生成的通用架构,从词曲唱三个方面来生成高质量的音乐作品。

仅需要输入几个字,就能生成情感表达精准的歌词,并且提供 10 余种不同的音乐风格和情绪表达,让旋律的演绎更丰富。

模型还支持图片成曲、灵感成曲、写词成曲多种创作方式,降低创作门槛,让人人都能“玩”音乐,不再是一句口号。

- 豆包同声传译模型

豆包同声传译模型采用端到端的模型架构,让翻译高精准、高质量,时延更低,还支持音色克隆,媲美真人同传效果,在很多专业场景上甚至比真人表现更好。

赤壁赋同声传译能力展示

3. 多个模型升级,综合表现大提升,细分场景更强劲

全新模型发布之外,豆包大模型家族也迎来升级。

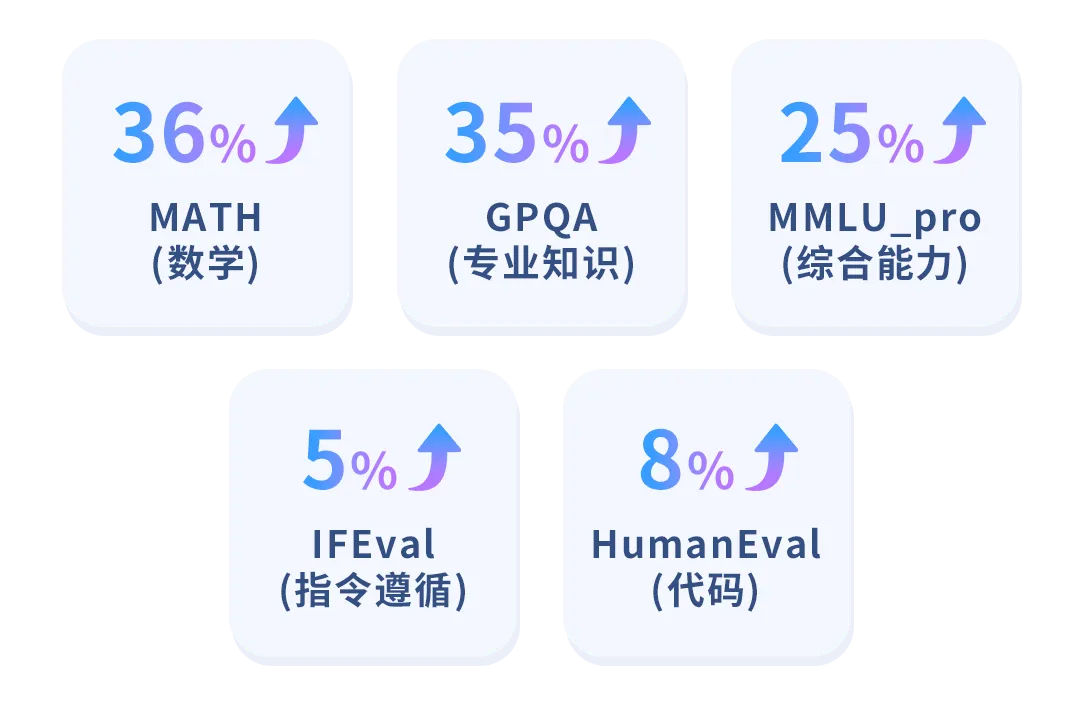

其中,主力模型“豆包通用模型 pro ”在 8 月底完成升级,面向 MMLU-pro 数据集综合能力提升 25% ,在各个维度均处于国内领先。

特别是数学能力和专业知识方面提升超过 35% ,指令遵循、代码等能力也在持续提升。面对复杂工作和生产场景,豆包的表现更加游刃有余。

值得一提的是,豆包通用模型 pro 的上下文窗口也进行了升级。原 pro 4k 版本将直接升级到 32k ,原来的 128k 版本将升级至达到 256k 。新窗口大小能处理约 40 万汉字,可将《三体》一口气读完。

语音合成模型也同样进行升级,上线了超强混音能力。

该能力基于 Seed-TTS ,可将不同角色和特征的声音进行混合,最终呈现效果非常自然,在连贯性、音质、韵律、气口等各方面表现媲美真人,可应用于沉浸式听书、陪伴式 AI 交互、语音导航等场景。

文生图模型也进行了迭代。

该版本模型采用了更高效的 DiT 架构,显著提升模型的推理效率和整体性能。尤其在复杂图文匹配、中国文化理解、极速模型出图方面表现突出。

具体来说,新模型能够精确呈现各类复杂场景的图文匹配关系。

面向现实场景,可实现多数量、多属性、大小、高矮、胖瘦和运动 6 类图文生成难点的精准匹配,生成内容更符合物理世界规律。

提示词:一个满脸胡须的男人拿着笔记本电脑,一个红色卷发的女人拿着平板电脑。

面向想象场景,模型在概念组合、角色创造和虚拟空间塑造方面展现出更强能力,尤其擅长生成奇幻小说和创意设计中的视觉画面。

提示词:卡通风格插图,二哈头上戴着一顶淡蓝色的棒球帽,戴着墨镜,一手拿着咖啡一手插兜。翘着二郎腿,坐在咖啡店前。

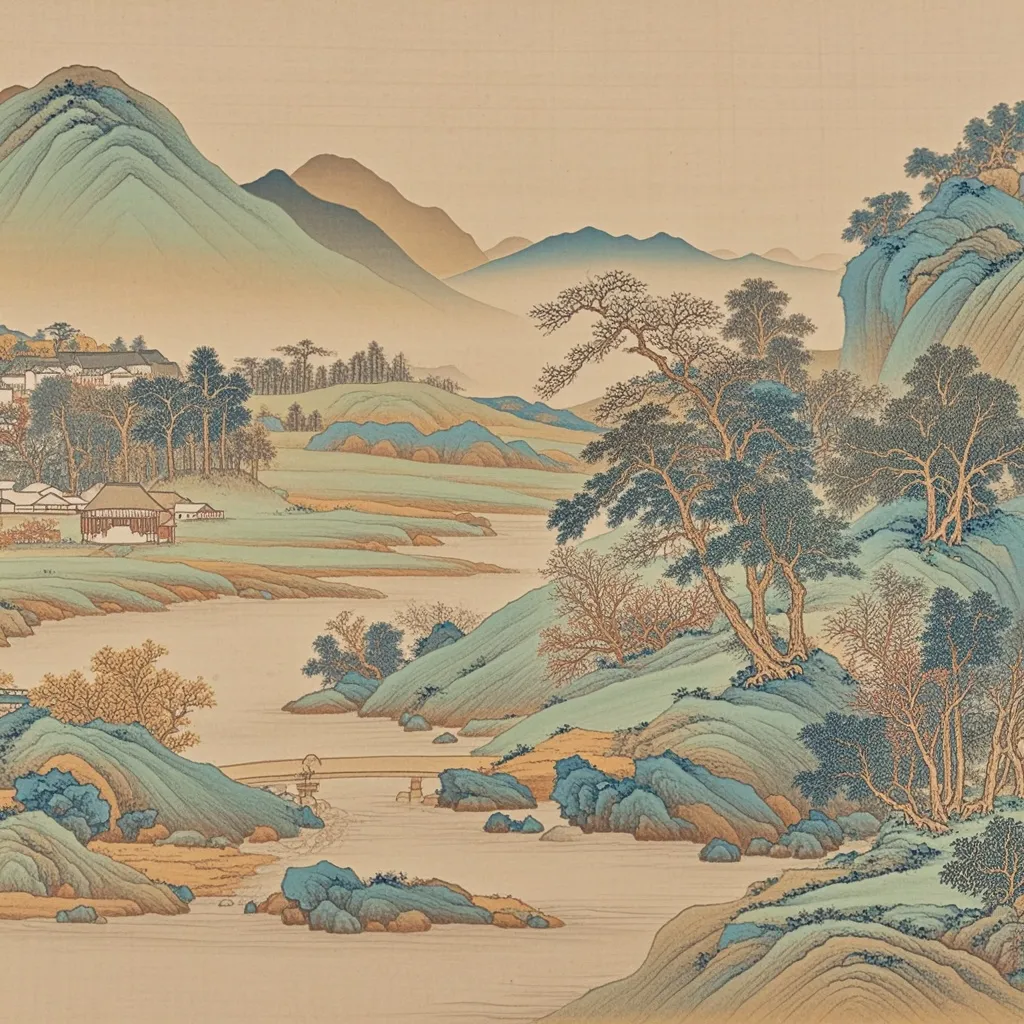

在中国古代绘画艺术的理解和呈现方面,模型也进行了升级,可更好地表现不同技法,如工笔画、写意画等。

提示词:画一幅山水画,千里江山风格。

至于工程方面,团队进行了工程全链路优化。同等参数下,推理消耗是 Flux 的 67% ,模型最快能做到 3 秒出图。

4. 写在最后

截至 9 月,豆包大模型的日均 tokens 调用量超过 1.3 万亿,4 个月的时间,整体增长超过 10 倍。

回顾本次发布,从视频生成模型、音乐模型及同声传译模型的发布,到文生图、语音合成方面的升级,豆包大模型家族成员更加丰富,模型能力持续升级,为多模态、多元化方面的落地应用打下了良好的基础。

其背后,是豆包大模型团队基于字节跳动丰富的业务场景,在基础模型研发上全面投入和发力。

豆包大模型团队将继续推进模型能力的不断升级与迭代,为产业界带来更多惊喜,敬请期待。

了解团队招聘信息,点击投递,加入豆包大模型团队。和优秀的人,做有挑战的事!