视频生成模型能否“理解”物理规律?豆包大模型团队公布系统性实验结论

视频生成模型能否“理解”物理规律?豆包大模型团队公布系统性实验结论

日期

2024-11-08

分类

技术发布

字节跳动豆包大模型团队近期发布成果 《How Far is Video Generation from World Model: A Physical Law Perspective》,该成果系统性分析了主流 DiT 架构视频生成模型究竟能否从数据集中抽象并理解物理规律,并为此进行了系统性实验。

本文介绍了此项研究的实验方法、探究过程与关键实验结果。

在人工智能研究中,我们始终追求让机器具备“类人智能”,不仅能够感知世界、理解规则,还能预测未来。

目前,视频生成模型已能生成全新的、前所未见的内容,在相关介绍中,这些模型往往被描述为——可遵循物理规律、对开发世界模型具有巨大潜力。然而,视频生成模型能否观察事物间的相互关系,并从中提炼出一套稳定的物理规律?这本身需要深入探究。

近期,字节跳动豆包大模型团队发布论文 《How Far is Video Generation from World Model: A Physical Law Perspective》,希望尝试回答这个问题。

How Far is Video Generation from World Model: A Physical Law Perspective

在本研究中,我们深入探讨了视频生成模型在学习物理定律时的泛化能力,尤其是在三种不同的泛化情境下:分布内泛化 (ID)、分布外泛化 (OOD) 和组合泛化。这些不同情境帮助我们全面理解——模型能否从数据中提取并应用普遍的物理规律。

- 分布内泛化 (In-Distribution, ID)

分布内泛化是指训练数据和测试数据来自同一分布。在我们的实验中,训练数据和测试数据位于相同的数值范围内。

- 分布外泛化 (Out-of-Distribution, OOD)

分布外泛化指的是模型在面对从未见过的新场景时,是否能够将已学过的物理定律应用到未知的情境。考察模型能否在没有直接经验的情况下,通过物理定律推测未知的物理现象,而不仅仅是死记硬背数据模式。这是模型是否学到物理规律的重要标准。

- 组合泛化 (Combinatorial Generalization)

组合泛化介于 ID 和 OOD 之间,具有更高的实际价值,用以考察模型如何将以前学习的不同信息组合成新的场景,并在测试时产生有效的预测。此种情况下,训练数据已包含了所有“概念”或物体,但这些概念、物体并未以所有可能的组合或更复杂的形式出现。

在基于视频的观察中,每一帧代表一个时间点,物理定律的预测则对应于根据过去和现在的帧生成未来的帧。因此,我们在每个实验中都训练一个基于帧条件的视频生成模型,来模拟和预测物理现象的演变。

通过测量生成视频每个帧(时间点)中物体位置变化,可判断其运动状态,进而与真实模拟的视频数据比对,判断生成内容是否符合经典物理学的方程表达。

1. 模型能学会领域内/外泛化吗?

在本次研究中,我们聚焦于由基本运动学方程支配的确定性任务。

这些任务允许我们清晰地定义分布内 (ID) 和分布外 (OOD) 泛化,并且能够进行直观的误差量化评估。

我们选择了以下三种物理场景进行评估,每种运动由其初始帧决定:

1. 匀速直线运动:一个球水平移动,速度保持恒定,用于说明惯性定律。

2. 完美弹性碰撞:两个具有不同大小和速度的球水平相向运动并发生碰撞,体现了能量与动量守恒定律。

3. 抛物线运动:一个带有初始水平速度的球因重力作用下落,符合牛顿第二定律。

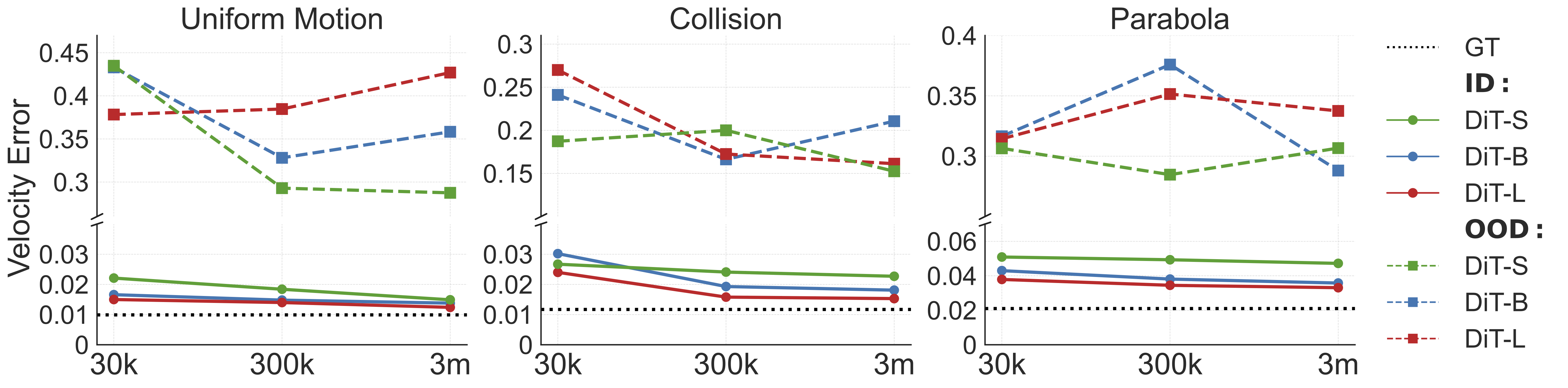

在分布内泛化(ID)的测试中,我们观察到,随着模型规模的增大(从 DiT-S 到 DiT-L)或训练数据量的增加(从 30K 到 3M),模型在所有三种物理任务中的速度误差都降低。这表明,模型规模和数据量的增加对分布内泛化至关重要。

然而,分布外泛化(OOD)与分布内泛化(ID)结果形成鲜明对比:

- 更高的误差:在所有设置中,OOD 速度误差比 ID 高出一个数量级 (~0.02 v.s. ~0.3)。

- 扩展数据和模型规模的影响有限:与分布内泛化不同,扩展训练数据和模型规模对降低 OOD 误差几乎没有影响。这表明,简单的数据量和模型规模的增加无法有效提升模型在 OOD 场景中的推理能力。

2. 模型能学习到组合泛化吗?

视频生成模型在处理分布外(OOD)场景时无法进行推理可以被理解,毕竟,从数据中提炼出精确的物理规律对人类同样非常困难。然而人类可以通过组合过往的经验来预测将要发生的事情。

在本节中,我们评估了基于扩散模型的视频生成在组合泛化能力方面的表现。

-

组合物理场景

我们使用了 PHYRE 模拟器评估模型的组合泛化能力。

PHYRE 是一个二维模拟环境,其中包括球、罐子、杆子和墙壁等多个对象,它们可以是固定或动态的,且能进行碰撞、抛物线轨迹、旋转等复杂物理交互,但环境中的底层物理规律是确定性的。

-

视频数据构造

每一个视频考虑了八种物体,包括两个动态灰色球、一组固定的黑色球、一个固定的黑色条形、一个动态条形、一组动态立式条形、一个动态罐子和一个动态立式棍子。

每个任务包含一个红色球和从这八种类型中随机选择的四个物体,总共形成 70 种独特的模板。数据示例如下:

对于每个训练模板,我们保留了一小部分视频用于创建模板内测试集(in-template evaluation set),再保留 10 个未使用的模板,用于模板外测试集(out-of-template evaluation set),以评估模型对训练时未见过的新组合的泛化能力。

-

结果分析

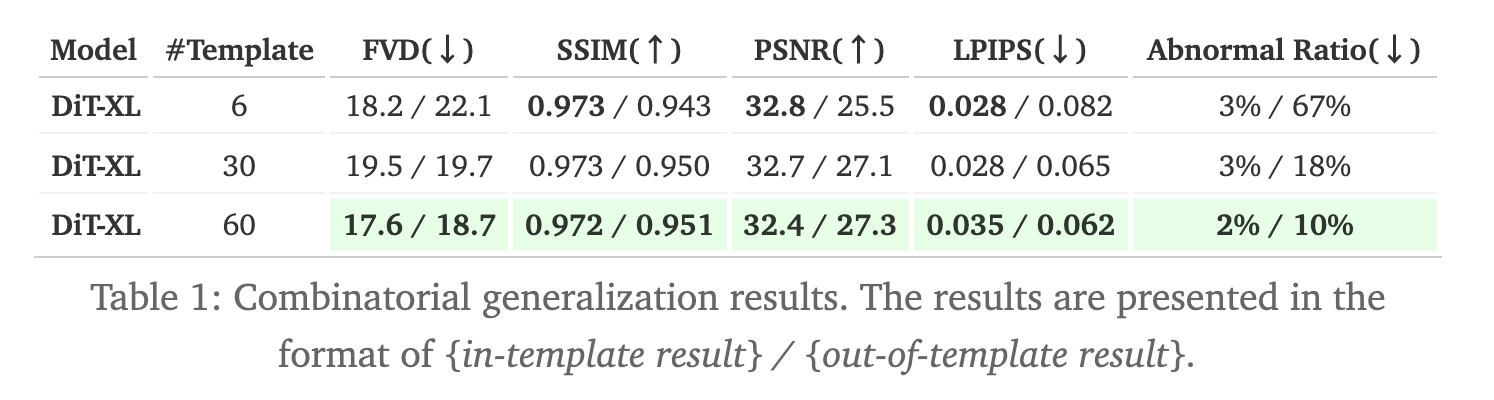

从下表可看到,当模板数量从 6 个增加到 60 个时,所有度量指标(FVD、SSIM、PSNR、LPIPS)在模版外测试集上均显著地提升。尤其是异常率(生成视频违背物理定律的比例),从 67% 大幅下降至 10%。这表明,当训练集覆盖了更多组合场景时,模型能够在未见过的组合中展现出更强的泛化能力。

然而,对于模板内测试集,模型在 6 个模板的训练集上的 SSIM、PSNR 和 LPIPS 等指标上表现最佳,因为每个训练示例被反复展示。

这些结果表明,模型容量和组合空间的覆盖范围对组合泛化至关重要。这意味着,视频生成的 Scaling Law 应当侧重于增加组合多样性,而不仅仅是扩大数据量。

注:在模版外测试集上生成的样本视频。第一行:真实视频。第二行:使用 60 个模板训练的模型生成的视频。第三行:使用 30 个模板训练的模型生成的视频。第四行:使用 6 个模板训练的模型生成的视频。

3. 机理探究:理解规律 or 模仿案例

前文提及,视频生成模型对于分布外泛化表现不佳,但在组合场景下,数据和模型 Scaling 可带来一定提升,这究竟来自于案例学习,还是对底层规律的抽象理解?我们进行了相关实验。

-

模型似乎更多依赖记忆和案例模仿

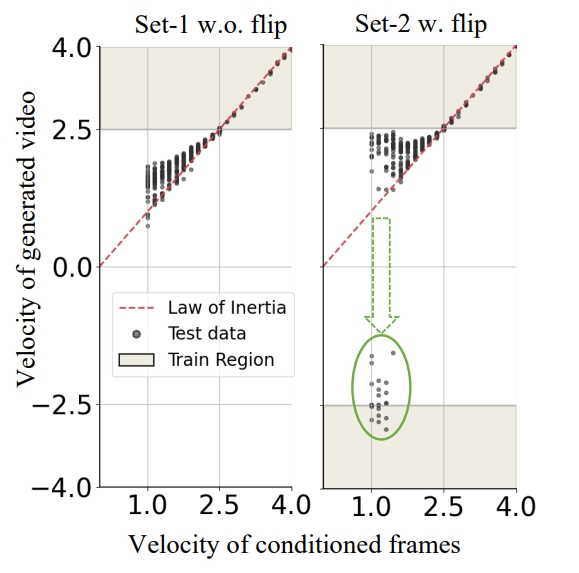

使用匀速运动视频进行训练,速度范围为 v∈[2.5, 4.0],并使用前 3 帧作为输入条件。我们使用两个数据集训练,再对照结果,Set-1 只包含从左到右移动的球,而 Set-2 则包含从左到右移动的球和从右到左移动的球。

如下图所示,给定进行低速正向(从左到右)运动的帧条件,Set-1 模型生成视频只有正速度,且偏向高速范围。相比之下,Set-2 模型偶尔会生成负速度的视频,正如图中绿色圆圈所示。

面对两者之间的区别,团队猜测,这可能是由于模型认为,与低速度球更接近的是训练数据中反方向运动的小球,导致模型受到训练数据中“误导性”示例影响。换而言之,模型似乎更多依赖于记忆和案例模仿,而非抽象出普遍的物理规则,实现分布外泛化(OOD)。

-

模型更多靠颜色寻找模仿对象

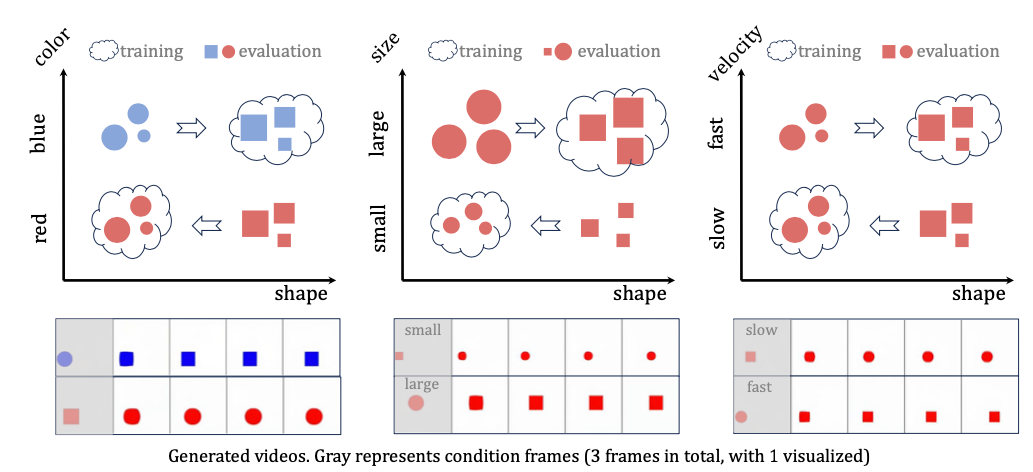

前文,我们已探索获知——模型更多依赖记忆和相似案例进行模仿并生成视频,更进一步,则须分析哪些属性对其模仿影响较大。

在比对颜色、形状、大小和速度四个属性后,我们发现,基于扩散技术的的视频生成模型天生更偏向其他属性而非形状,这也可能解释了为什么当前的开放集视频生成模型通常在形状保持上存在困难。

如下方展示,第一行是真实视频,第二行是我们模型生成的视频,颜色很好的保持了一致,但其形状难以保持。

两两对比后,团队发现视频生成模型更习惯于通过“颜色”寻找相似参考生成物体运动状态,其次是大小,再次是速度,最后才是形状。颜色/大小/速度对形状的影响情况如下图:

-

复杂组合泛化情况

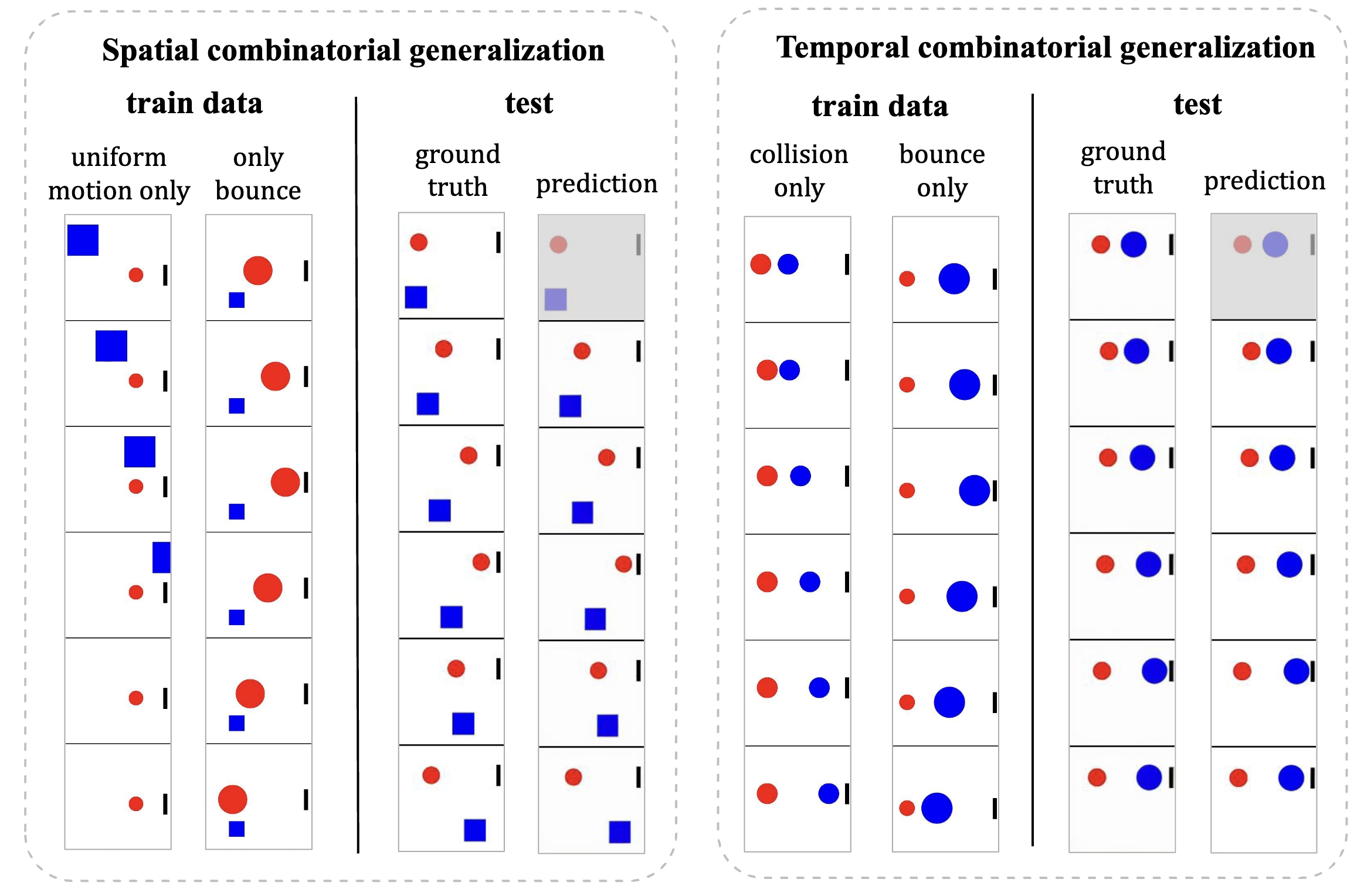

最后,对于复杂的组合泛化为何能够发生,团队提出视频模型具有三种基本的组合模式,分别为:属性组合、空间组合(多个物体不同运动状态)、时间组合(不同的时间点多个物体的不同状态)。

实验结果发现,对于速度与大小或颜色与大小等属性对,模型展现出一定程度的组合泛化能力。同时,如下图所示,模型能够通过对训练数据的局部片段进行时间/空间维度的再组合。

然而值得注意的是,并不是所有的情况下都能通过组合泛化生成遵循物理规律的视频。模型对案例匹配的依赖限制了其效果。在不了解底层规则的情况下,模型检索并组合片段,可能会生成不符合现实的结果。

-

视频表征的局限性

最后,团队探索了在视频表征空间进行生成是否足以作为世界模型,结果发现,视觉模糊性会导致在细粒度物理建模方面出现显著的误差。

例如,当物体尺寸差异仅在像素级别时,单纯通过视觉判断一个球是否能通过间隙变得十分困难,这可能导致看似合理但实际上错误的结果。

注:第一行是真实视频,第二行是我们模型生成的视频。

这些发现表明,单纯依赖视频表示不足以进行精确的物理建模。

更多有趣的实验设计、结论和开放讨论请阅读论文原文。

4. 写在最后:一位 95 后和一位 00 后做出来的研究

本研究的两位一作都非常年轻,一位是 95 后,一位是 00 后,在豆包大模型团队专注视觉领域的基础研究工作。作者们一直对世界模型感兴趣,在 8 个月“玩一般”的探索中,他们阅读了大量 Physical Reasoning 研究文献,也尝试从游戏中获得研发灵感,历经多次“闯关”失败后,最终一步步确定了研究思路和实验方法。

早在 2023 年加入字节时,95 后康同学便开始构思“世界模型”相关研究。Sora 爆火后,他决定先从视频生成模型能否真正理解物理规律入手,一步步揭开世界模型机理。

最初,康同学打算给模型投喂“愤怒的小鸟”之类的游戏视频,场景中包含抛物线运动、碰撞等经典物理运动,但苦于对游戏视频做定量分析非常困难。后来,在阅读了至少上百篇物理推理方向论文后,康同学团队将思路收敛到用物理引擎合成运动视频上,这一方法可以最大程度排除干扰变量,并提供无限的视频数据。从研究立项,到设计完实验,2 个月过去了。

跑实验前,两个年轻人一起动手,专门为实验设计开发了物理引擎。接着,有三四个月的时间两人都在紧锣密鼓地生视频、训模型、做实验,模型大小从几十 M 扩大到了几百 M,实验数据也从几十 K 飙升到几个 M。

得出实验结论,思考模型背后行为原因时,研究又陷入停滞。有三四周时间,项目毫无进展,直到一次实验,大家注意到一个很隐蔽的反常规现象,借此设计对比试验后,他们确认了“模型其实不是在总结规律,而是在匹配最接近的样本”。

“做 research 往往不是说,你突然有个很好的 idea,然后你一试它就 work 了,很多时候你都是在排错。但经过一段时间的试错,你很可能突然发现某一个方向有解了。”康同学表示。

尽管研究耗时 8 个月,每天对着视频中的虚拟小球做定量实验,但康同学更多感受到的不是枯燥,而是“好玩”和“烧脑”,回忆这段,康同学感慨:“团队对基础研究给了充分的探索空间”。

另一位 00 后同学分享,这项研究是他经历过的最具挑战性、最耗时的项目,涉及对物理引擎、评测系统、实验方法的构建,非常繁琐,当中还有好几次项目“卡顿”住。不过,团队负责人和 Mentor 都给予了耐心和鼓励,“没人催赶紧把项目做完”。

目前,豆包大模型团队视觉研究方向相关岗位仍在招聘中,点击投递,了解岗位信息。